Con 1.16 miliardi di utenti, ChatGPT è diventata una parte inseparabile della vita di molte persone. Questa significativa base di utenti richiede che i team IT e di sicurezza trovino e implementino una soluzione nel loro stack in grado di proteggere l'organizzazione dalle sue potenziali vulnerabilità della sicurezza.

Non si tratta di un rischio ipotetico; sono già state pubblicate numerose segnalazioni di potenziali violazioni della sicurezza informatica che coinvolgono ChatGPT. In questo post del blog esploriamo questi rischi e scopriamo quale soluzione di sicurezza può aiutare a proteggere dalla vulnerabilità della fuga di dati.

Per saperne di più su come la soluzione di sicurezza del browser LayerX può proteggere la tua organizzazione da potenziali fughe di dati che potrebbero derivare dall'uso da parte dei dipendenti di ChatGPT o di altri strumenti di intelligenza artificiale generativa. Per saperne di più qui

Punti ciechi nella protezione dei dati di ChatGPT

La famigerata perdita di Samsung ChatGPT (che sta rapidamente diventando il “SolarWinds” delle violazioni della sicurezza informatica dell’intelligenza artificiale generativa) è diventata un esempio rappresentativo delle vulnerabilità della sicurezza informatica che affliggono le piattaforme di intelligenza artificiale generativa. Nella debacle di Samsung, gli ingegneri hanno incollato il codice proprietario in ChatGPT. Poiché tutto ciò che viene incollato in ChatGPT potrebbe essere utilizzato per la formazione e per le risposte fornite ad altri utenti, questi ingegneri potenzialmente condividono il codice riservato con eventuali concorrenti che sanno porre a ChatGPT le domande giuste.

ChatGPT potrebbe sembrare uno strumento obiettivo e orientato alla produttività. Tuttavia, in realtà è un potenziale canale di fuga di dati. Per inciso, quando si chiede a ChatGPT se presenta il rischio di fuga di dati, la risposta è: “Essendo un modello di linguaggio AI, non ho alcuna motivazione intrinseca o capacità di perdere dati. Tuttavia, qualsiasi sistema che archivia dati presenta un potenziale rischio di perdita di dati o altre vulnerabilità della sicurezza…”

I ricercatori di sicurezza hanno già dimostrato come è possibile sfruttare ChatGPT e le sue API scrivere malware, Come I bug di ChatGPT hanno creato fughe di dati personalie anche il modo in cui i prompt possono essere utilizzati per estrarre informazioni sensibili condivise da altri utenti. Dato che le piattaforme di intelligenza artificiale generativa sono destinate a guadagnare maggiore popolarità nei prossimi anni, spetta ai soggetti interessati e ai team di sicurezza proteggere la propria organizzazione dalla possibilità che le informazioni del loro gioiello della corona vengano divulgate sull'Internet pubblica, a causa di errori umani, errori o errori. semplicemente ingenuità.

Dove DLP e CASB falliscono

Tradizionalmente, le aziende si affidavano a soluzioni DLP (Data Leak Prevention) per proteggere i dati aziendali sensibili dall'accesso o dalla distribuzione non autorizzati. Le DLP monitorano il flusso di dati sensibili nell'organizzazione. Una volta identificata una violazione della policy, ad esempio un utente non autorizzato che tenta di accedere a una risorsa riservata, il DLP agirà e risponderà di conseguenza. Ciò potrebbe includere il blocco dei dati o l'avviso degli amministratori. Potrebbero essere utilizzate anche soluzioni CASB per proteggere i dati sensibili dalla trasmissione all'esterno dell'organizzazione.

Tuttavia, sia DLP che Soluzioni CASB sono orientati ai file. Ciò significa che mentre impediscono azioni come la modifica, il download o la condivisione dei dati, questa prevenzione viene applicata ai file. Con i dipendenti che digitano o incollano dati nel browser sul sito Web ChatGPT, DLP e CASB non sono più utili. Queste azioni basate su browser vanno oltre la loro governance e controllo.

Cos'è la sicurezza del browser?

La sicurezza del browser comprende le tecnologie, gli strumenti, le piattaforme e le pratiche che consentono l'accesso ad applicazioni e siti Web SaaS salvaguardando i sistemi e i dati organizzativi. Utilizzando una soluzione di sicurezza del browser, le aziende possono rilevare e prevenire minacce e rischi basati sul Web che prendono di mira il browser o lo utilizzano come vettore di attacco. Tali minacce includono malware, ingegneria sociale, furto di dati ed esfiltrazione di dati.

A differenza delle soluzioni di sicurezza di rete e degli endpoint, le piattaforme di sicurezza del browser si concentrano sull'attività delle sessioni web in tempo reale, che comprende le pagine web effettive non crittografate che i browser eseguono e visualizzano. Le soluzioni di sicurezza del browser funzionano identificando e bloccando le minacce trasmesse dal Web, attraverso policy di attività, impedendo la condivisione dei dati, applicando il privilegio minimo, fornendo visibilità, rilevando attività dannose e proteggendo i dispositivi gestiti e BYOD/di terze parti. In quanto tali, possono essere utilizzati per proteggere le attività in ChatGPT.

In che modo la soluzione di sicurezza del browser LayerX previene le fughe di dati su ChatGPT

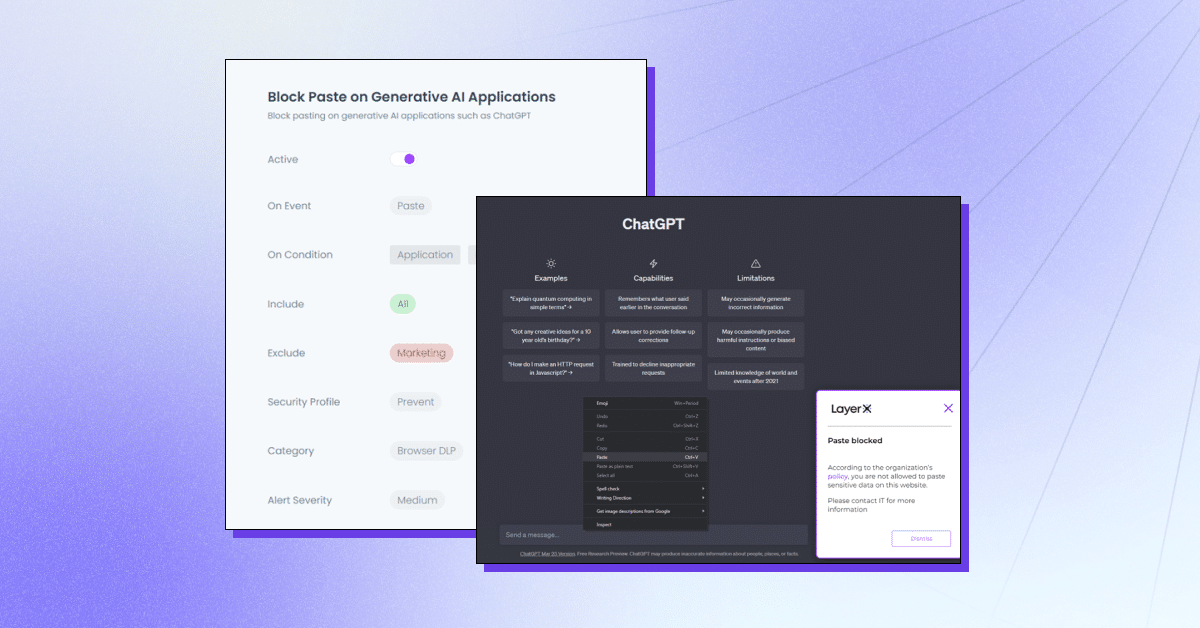

LayerX è una piattaforma di sicurezza del browser orientata all'utente che funziona con qualsiasi browser commerciale, trasformandolo nello spazio di lavoro più protetto e gestibile. LayerX monitora e analizza continuamente le sessioni del browser per rafforzarne la protezione in tempo reale. Attraverso una visibilità granulare su ogni evento che avviene nella sessione, layerX può individuare gli eventi di inserimento del testo. Tutto ciò che i team di sicurezza devono fare è definire una policy che limiti o blocchi questa capacità con la scheda ChatGPT. Questa politica può essere onnicomprensiva, ovvero impedire l'uso di ChatGPT del tutto o per stringhe specifiche.

LayerX offre molteplici funzionalità per proteggere dalla perdita di dati ChatGPT:

- Impedire l'incollamento o l'invio di dati – Garantire che i dipendenti non aggiungano informazioni sensibili alla piattaforma di intelligenza artificiale generativa.

- Rilevamento della digitazione di dati sensibili – Identificare quando i dipendenti stanno per inviare dati sensibili a ChatGPT e limitarli.

- Modalità di avviso – Partecipare alla formazione dei dipendenti mentre utilizzano ChatGPT aggiungendo linee guida sull'uso sicuro.

- Blocco o disabilitazione del sito – Impedire del tutto l'uso di ChatGPT o di estensioni del browser simili a ChatGPT.

- Richiedere il consenso/giustificazione dell'utente – Garantire l’approvazione dell’uso di uno strumento di intelligenza artificiale generativa.

LayerX proteggerà la tua organizzazione da potenziali fughe di dati che potrebbero derivare dall'uso da parte dei dipendenti di ChatGPT o di altri strumenti di intelligenza artificiale generativa. Per saperne di più qui.