Da ChatGPT er 1.16 milliarder brugere, er det blevet en uadskillelig del af mange menneskers liv. Denne betydelige brugerbase kræver, at sikkerheds- og it-teams finder og implementerer en løsning i deres stak, der kan beskytte organisationen mod dens potentielle sikkerhedssårbarheder.

Dette er ikke en hypotetisk risiko; adskillige rapporter om potentielle cybersikkerhedsbrud, der involverer ChatGPT, er allerede blevet offentliggjort. I dette blogindlæg udforsker vi disse risici og finder ud af, hvilken sikkerhedsløsning der kan hjælpe med at beskytte mod datalækage-sårbarheden.

For at læse mere om, hvordan LayerX-browsersikkerhedsløsning kan beskytte din organisation mod potentiel datalækage, der kan skyldes medarbejdernes brug af ChatGPT eller andre Generative AI-værktøjer. Læs mere her

ChatGPTs databeskyttelses blinde vinkler

Det berygtede Samsung ChatGPT-læk (som hurtigt er ved at blive 'SolarWinds' for generative AI-cybersikkerhedsbrud) er blevet et repræsentativt eksempel på de cybersikkerhedssårbarheder, der plager generative AI-platforme. I Samsung-debaclet indsatte ingeniører proprietær kode i ChatGPT. Da alt indsat i ChatGPT kunne bruges til træning og til svarene givet til andre brugere, deler disse ingeniører potentielt fortrolig kode med alle konkurrenter, der ved, hvordan man stiller ChatGPT de rigtige spørgsmål.

ChatGPT kan virke som et objektivt, produktivitetsfremmende værktøj. Det er dog faktisk en potentiel datalækagekanal. I øvrigt, når man spørger ChatGPT, om det har potentiale for datalækage, er svaret "Som en AI-sprogmodel har jeg ikke nogen iboende motivation eller evne til at lække data. Men ethvert system, der gemmer data, har en potentiel risiko for datalækage eller andre sikkerhedssårbarheder..."

Sikkerhedsforskere har allerede demonstreret, hvordan ChatGPT og dets API'er kan udnyttes til skrive malware, hvordan ChatGPT-fejl skabte personlige datalæk, og endda hvordan prompter kan bruges til at udtrække følsomme oplysninger, der deles af andre brugere. I betragtning af at Generative AI-platforme er klar til at vinde større popularitet i de kommende år, er det op til sikkerhedsinteressenter og -teams at sikre deres organisation mod muligheden for, at deres kronjuveloplysninger bliver lækket til det offentlige internet på grund af menneskelige fejl, fejlslutning eller bare ren naivitet.

Hvor DLP og CASB kommer til kort

Traditionelt stolede virksomheder på DLP-løsninger (Data Leak Prevention) for at beskytte følsomme organisationsdata mod uautoriseret adgang eller distribution. DLP'er overvåger strømmen af følsomme data i organisationen. Når de identificerer en politik, der er blevet overtrådt, for eksempel en uautoriseret bruger, der forsøger at få adgang til en begrænset ressource, DLP vil tage affære og reagere i overensstemmelse hermed. Dette kan omfatte blokering af data eller advarsel til administratorer. CASB-løsninger kan også bruges til at beskytte følsomme data fra at blive transmitteret uden for organisationen.

Men både DLP og CASB løsninger er filorienterede. Dette betyder, at selvom de forhindrer handlinger som dataændring, download eller deling, anvendes denne forebyggelse på filer. Når medarbejdere skriver eller indsætter data i browseren på ChatGPT-webstedet, er DLP'er og CASB'er til ingen nytte. Disse browserbaserede handlinger er uden for deres styring og kontrol.

Hvad er browsersikkerhed?

Browsersikkerhed er de teknologier, værktøjer, platforme og praksis, der muliggør adgang til SaaS-applikationer og websteder, samtidig med at de organisatoriske systemer og data beskyttes. Ved at bruge en browsersikkerhedsløsning kan virksomheder opdage og forhindre webbaserede trusler og risici, der målretter browseren eller bruger den som angrebsvektor. Sådanne trusler omfatter malware, social engineering, datatyveri og dataeksfiltrering.

I modsætning til netværks- og slutpunktsikkerhedsløsninger fokuserer browsersikkerhedsplatforme på live websessionsaktivitet, som omfatter de faktiske ikke-krypterede websider, som browsere gengiver og viser. Browsersikkerhedsløsninger fungerer ved at identificere og blokere netbårne trusler gennem aktivitetspolitikker, forhindre datadeling, håndhæve mindste privilegier, give synlighed, opdage ondsindede aktiviteter og sikre både administrerede og BYOD/tredjepartsenheder. Som sådan kan de bruges til at sikre aktiviteter i ChatGPT.

Hvordan LayerX Browser Security Solution forhindrer datalækage til ChatGPT

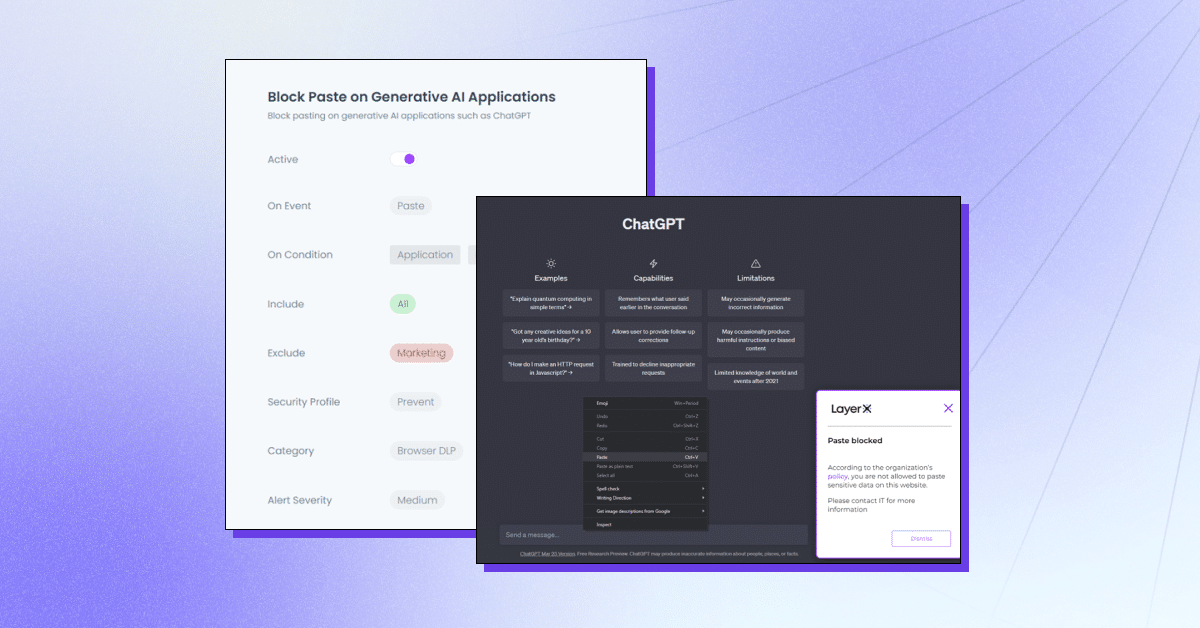

LayerX er en brugerførste browsersikkerhedsplatform, der fungerer med enhver kommerciel browser, og gør den til det mest beskyttede og håndterbare arbejdsområde. LayerX overvåger og analyserer løbende browsersessioner for at håndhæve deres beskyttelse i realtid. Gennem detaljeret synlighed i hver begivenhed, der finder sted i sessionen, kan layerX udskille tekstindsættelseshændelser. Alt, hvad sikkerhedsteam skal gøre, er at definere en politik, der begrænser eller blokerer denne evne med fanen ChatGPT. Denne politik kan være altomfattende, dvs. forhindre brugen af ChatGPT helt, eller for specifikke strenge.

LayerX'er tilbyder flere muligheder for at beskytte mod ChatGPT-datalækage:

- Forhindring af indsættelse eller indsendelse af data – Sikre, at medarbejdere ikke tilføjer følsomme oplysninger til Generative AI-platformen.

- Registrering af indtastning af følsomme data – Identifikation af, hvornår medarbejdere er ved at indsende følsomme data til ChatGPT og begrænsning af det.

- Advarselstilstand – Deltagelse i medarbejdertræning, mens de bruger ChatGPT ved at tilføje retningslinjer for "sikker brug".

- Blokering eller deaktivering af websted – Forhindring af brugen af ChatGPT helt eller ChatGPT-lignende browserudvidelser.

- Kræv brugerens samtykke/begrundelse – Sikring af, at brugen af et generativt AI-værktøj er godkendt.

LayerX vil beskytte din organisation mod potentiel datalækage, der kan skyldes medarbejdernes brug af ChatGPT eller andre Generative AI-værktøjer. Læs mere her.