Eftersom ChatGPT har 1.16 miljarder användare har det blivit en oskiljaktig del av många människors liv. Denna betydande användarbas kräver att säkerhets- och IT-team hittar och implementerar en lösning i sin stack som kan skydda organisationen från dess potentiella säkerhetsbrister.

Detta är inte en hypotetisk risk; många rapporter om potentiella cybersäkerhetsintrång som involverar ChatGPT har redan publicerats. I det här blogginlägget utforskar vi dessa risker och tar reda på vilken säkerhetslösning som kan hjälpa till att skydda mot sårbarheten för dataläckage.

För att läsa mer om hur LayerX webbläsarsäkerhetslösning kan skydda din organisation från potentiellt dataläckage som kan uppstå från anställdas användning av ChatGPT eller andra Generativa AI-verktyg. Läs mer här

ChatGPT:s dataskydds blinda fläckar

Den ökända Samsung ChatGPT-läckan (som snabbt håller på att bli "SolarWinds" av generativa AI-cybersäkerhetsbrott) har blivit ett representativt exempel på cybersäkerhetssårbarheter som plågar generativa AI-plattformar. I Samsung-debaclet klistrade ingenjörer in proprietär kod i ChatGPT. Eftersom allt som klistrats in i ChatGPT kan användas för utbildning och för svaren som ges till andra användare, delar dessa ingenjörer potentiellt konfidentiell kod med alla konkurrenter som vet hur man ställer ChatGPT de rätta frågorna.

ChatGPT kan verka som ett objektivt, produktivitetsdrivande verktyg. Men det är faktiskt en potentiell dataläckagekanal. För övrigt, när man frågar ChatGPT om det har potential för dataläckage, är svaret "Som en AI-språkmodell har jag ingen inneboende motivation eller förmåga att läcka data. Men alla system som lagrar data har en potentiell risk för dataläckage eller andra säkerhetsbrister..."

Säkerhetsforskare har redan visat hur ChatGPT och dess API:er kan utnyttjas till skriva skadlig programvara, på vilket sätt ChatGPT-buggar skapade personliga dataläckor, och till och med hur uppmaningar kan användas för att extrahera känslig information som delas av andra användare. Med tanke på att Generative AI-plattformar är redo att vinna större popularitet under de kommande åren, är det upp till säkerhetsintressenter och team att säkra sin organisation från möjligheten att deras kronjuvelinformation läcker ut på det offentliga internet, på grund av mänskliga fel, felaktigheter eller bara ren naivitet.

Där DLP och CASB kommer till korta

Traditionellt har företag förlitat sig på DLP-lösningar (Data Leak Prevention) för att skydda känslig organisationsdata från obehörig åtkomst eller distribution. DLP:er övervakar flödet av känslig data i organisationen. När de identifierar en policy som bryter mot, till exempel en obehörig användare som försöker komma åt en begränsad resurs, DLP kommer att vidta åtgärder och svara därefter. Detta kan inkludera blockering av data eller varna administratörer. CASB-lösningar kan också användas för att skydda känslig data från att överföras utanför organisationen.

Men både DLP och CASB-lösningar är filorienterade. Detta innebär att även om de förhindrar åtgärder som datamodifiering, nedladdning eller delning, tillämpas detta på filer. När anställda skriver eller klistrar in data i webbläsaren på ChatGPT-webbplatsen är DLP:er och CASB:er till ingen nytta. Dessa webbläsarbaserade åtgärder ligger utanför deras styrning och kontroll.

Vad är webbläsarsäkerhet?

Webbläsarsäkerhet är de teknologier, verktyg, plattformar och metoder som möjliggör åtkomst till SaaS-applikationer och webbplatser samtidigt som de skyddar organisationssystem och data. Genom att använda en webbläsarsäkerhetslösning kan företag upptäcka och förhindra webbaserade hot och risker som riktar sig mot webbläsaren eller använder den som en attackvektor. Sådana hot inkluderar skadlig programvara, social ingenjörskonst, datastöld och dataexfiltrering.

Till skillnad från nätverks- och slutpunktssäkerhetslösningar fokuserar webbläsarsäkerhetsplattformar på live webbsessionsaktivitet, som omfattar de faktiska icke-krypterade webbsidorna som webbläsare renderar och visar. Webbläsarsäkerhetslösningar fungerar genom att identifiera och blockera webburna hot, genom aktivitetspolicyer, förhindra datadelning, upprätthålla minsta privilegium, tillhandahålla synlighet, upptäcka skadliga aktiviteter och säkra både hanterade och BYOD/tredjepartsenheter. Som sådana kan de användas för att säkra aktiviteter i ChatGPT.

Hur LayerX Browser Security Solution förhindrar dataläckor till ChatGPT

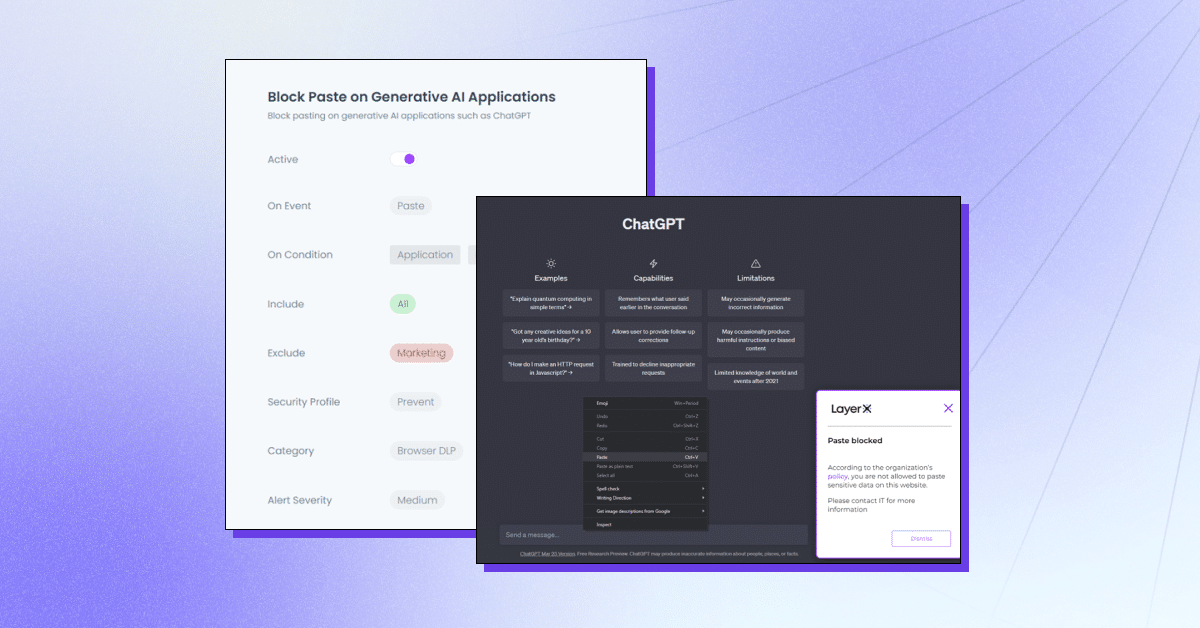

LayerX är en användarförsta säkerhetsplattform för webbläsare som fungerar med alla kommersiella webbläsare, vilket gör den till den mest skyddade och hanterbara arbetsytan. LayerX övervakar och analyserar kontinuerligt webbläsarsessioner för att upprätthålla deras skydd i realtid. Genom granulär synlighet i varje händelse som äger rum i sessionen kan layerX peka ut textinfogningshändelser. Allt säkerhetsteam behöver göra är att definiera en policy som begränsar eller blockerar denna förmåga med ChatGPT-fliken. Denna policy kan vara allomfattande, dvs förhindra användning av ChatGPT helt, eller för specifika strängar.

LayerX erbjuder flera funktioner för att skydda mot ChatGPT-dataläckage:

- Förhindra inklistring eller inlämning av data – Se till att anställda inte lägger till känslig information i Generative AI-plattformen.

- Upptäcker känslig datainmatning – Identifiera när anställda är på väg att skicka känslig information till ChatGPT och begränsa den.

- Varningsläge – Att delta i utbildning av anställda medan de använder ChatGPT genom att lägga till riktlinjer för "säker användning".

- Webbplatsblockering eller inaktivering – Förhindra användningen av ChatGPT helt och hållet eller ChatGPT-liknande webbläsartillägg.

- Kräv användarens samtycke/motivering – Säkerställa att användningen av ett generativt AI-verktyg är godkänt.

LayerX kommer att skydda din organisation från potentiellt dataläckage som kan bli resultatet av anställdas användning av ChatGPT eller andra Generativa AI-verktyg. Läs mer här.