Dado que ChatGPT tiene 1.16 millones de usuarios, se ha convertido en una parte inseparable de la vida de muchas personas. Esta importante base de usuarios requiere que los equipos de seguridad y TI encuentren e implementen una solución en su pila que pueda proteger a la organización de sus posibles vulnerabilidades de seguridad.

Este no es un riesgo hipotético; Ya se han publicado numerosos informes sobre posibles violaciones de ciberseguridad que involucran a ChatGPT. En esta publicación de blog, exploramos estos riesgos y descubrimos qué solución de seguridad puede ayudar a proteger contra la vulnerabilidad de fuga de datos.

Para leer más sobre cómo la solución de seguridad del navegador LayerX puede proteger a su organización de posibles fugas de datos que podrían resultar del uso de ChatGPT u otras herramientas de IA generativa por parte de los empleados. Más información aquí

Puntos ciegos de protección de datos de ChatGPT

La infame filtración de Samsung ChatGPT (que rápidamente se está convirtiendo en los 'SolarWinds' de las violaciones de ciberseguridad de la IA generativa) se ha convertido en un ejemplo representativo de las vulnerabilidades de ciberseguridad que afectan a las plataformas de IA generativa. En la debacle de Samsung, los ingenieros pegaron código propietario en ChatGPT. Dado que todo lo pegado en ChatGPT podría usarse para capacitación y para las respuestas dadas a otros usuarios, estos ingenieros potencialmente comparten código confidencial con cualquier competidor que sepa cómo hacerle las preguntas correctas a ChatGPT.

ChatGPT puede parecer una herramienta objetiva que impulsa la productividad. Sin embargo, en realidad es un canal potencial de fuga de datos. Por cierto, cuando se le pregunta a ChatGPT si tiene potencial de fuga de datos, la respuesta es “Como modelo de lenguaje de IA, no tengo ninguna motivación o capacidad inherente para filtrar datos. Sin embargo, cualquier sistema que almacene datos tiene un riesgo potencial de fuga de datos u otras vulnerabilidades de seguridad…”

Los investigadores de seguridad ya han demostrado cómo se pueden explotar ChatGPT y sus API para escribir software malicioso, Cómo Los errores de ChatGPT crearon filtraciones de datos personales, e incluso cómo se pueden utilizar las indicaciones para extraer información confidencial compartida por otros usuarios. Dado que las plataformas de IA generativa están preparadas para ganar mayor popularidad en los próximos años, depende de las partes interesadas y los equipos de seguridad proteger su organización de la posibilidad de que la información de su joya de la corona se filtre en la Internet pública, debido a un error humano, falacia o simplemente ingenuidad.

Donde DLP y CASB se quedan cortos

Tradicionalmente, las empresas confiaban en soluciones DLP (prevención de fugas de datos) para proteger los datos organizacionales confidenciales contra el acceso o la distribución no autorizados. Las DLP monitorean el flujo de datos confidenciales en la organización. Una vez que identifican una política que se está violando, por ejemplo, un usuario no autorizado que intenta acceder a un recurso restringido, el DLP tomará medidas y responderá en consecuencia. Esto podría incluir bloquear los datos o alertar a los administradores. También se pueden utilizar soluciones CASB para proteger los datos confidenciales de la transmisión fuera de la organización.

Sin embargo, tanto DLP como Soluciones CASB están orientados a archivos. Esto significa que, si bien impiden acciones como modificar, descargar o compartir datos, esta prevención se aplica a los archivos. Cuando los empleados escriben o pegan datos en el navegador del sitio web ChatGPT, los DLP y CASB no sirven de nada. Estas acciones basadas en navegadores están más allá de su gobernanza y control.

¿Qué es la seguridad del navegador?

La seguridad del navegador son las tecnologías, herramientas, plataformas y prácticas que permiten el acceso a aplicaciones y sitios web SaaS mientras protegen los sistemas y datos de la organización. Al utilizar una solución de seguridad del navegador, las empresas pueden detectar y prevenir amenazas y riesgos basados en la web que se dirigen al navegador o lo utilizan como vector de ataque. Dichas amenazas incluyen malware, ingeniería social, robo de datos y exfiltración de datos.

A diferencia de las soluciones de seguridad de redes y terminales, las plataformas de seguridad del navegador se centran en la actividad de la sesión web en vivo, que abarca las páginas web reales no cifradas que los navegadores representan y muestran. Las soluciones de seguridad del navegador operan identificando y bloqueando amenazas transmitidas por la web, a través de políticas de actividad, evitando el intercambio de datos, aplicando privilegios mínimos, brindando visibilidad, detectando actividades maliciosas y protegiendo los dispositivos administrados y BYOD/de terceros. Como tales, se pueden utilizar para proteger actividades en ChatGPT.

Cómo la solución de seguridad del navegador LayerX previene la fuga de datos a ChatGPT

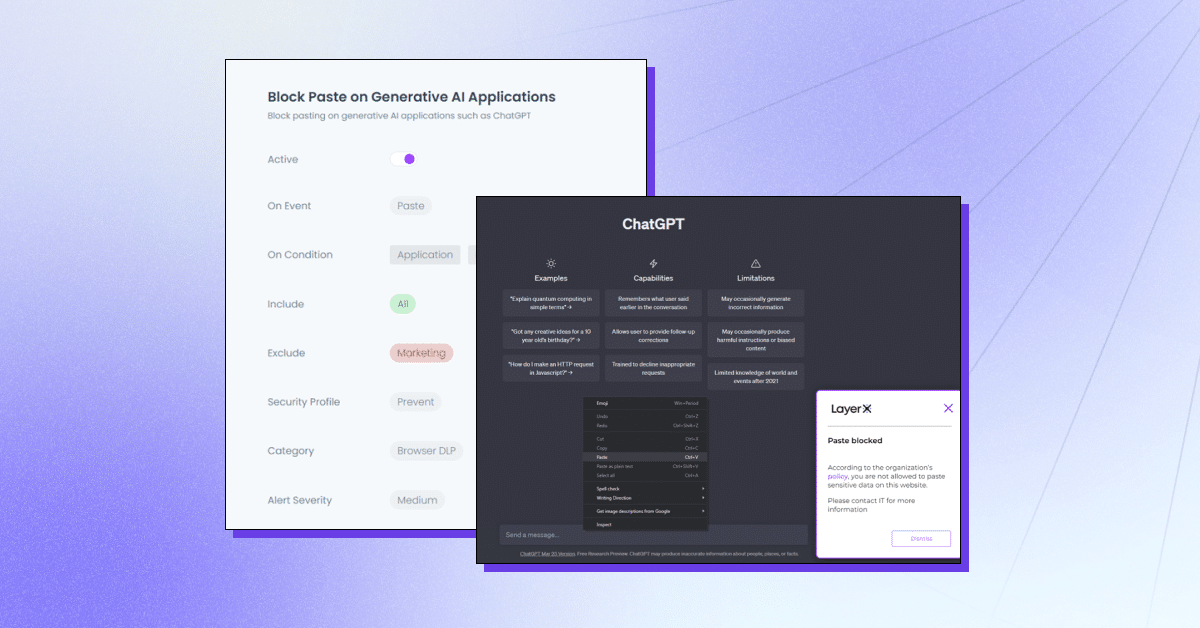

LayerX es una plataforma de seguridad para navegadores prioritaria para el usuario que funciona con cualquier navegador comercial, convirtiéndolo en el espacio de trabajo más protegido y manejable. LayerX monitorea y analiza continuamente las sesiones del navegador para hacer cumplir su protección en tiempo real. A través de una visibilidad granular de cada evento que tiene lugar en la sesión, LayerX puede identificar eventos de inserción de texto. Todo lo que los equipos de seguridad deben hacer es definir una política que limite o bloquee esta capacidad con la pestaña ChatGPT. Esta política puede abarcar todo, es decir, impedir el uso de ChatGPT por completo o para cadenas específicas.

LayerX ofrece múltiples capacidades para protegerse contra la fuga de datos de ChatGPT:

- Impedir el pegado o envío de datos – Garantizar que los empleados no agreguen información confidencial a la plataforma de IA generativa.

- Detección de escritura de datos confidenciales – Identificar cuándo los empleados están a punto de enviar datos confidenciales a ChatGPT y restringirlos.

- Modo de advertencia – Participar en la capacitación de los empleados mientras usan ChatGPT agregando pautas de “uso seguro”.

- Bloqueo o deshabilitación del sitio – Impedir el uso de ChatGPT por completo o extensiones de navegador similares a ChatGPT.

- Requerir consentimiento/justificación del usuario – Garantizar que se apruebe el uso de una herramienta de IA generativa.

LayerX protegerá a su organización de posibles fugas de datos que podrían resultar del uso de ChatGPT u otras herramientas de IA generativa por parte de los empleados. Más información aquí.