ChatGPT拥有1.16亿用户,已经成为许多人生活中不可分割的一部分。这一重要的用户群要求安全和 IT 团队在其堆栈中找到并实施一个解决方案,以保护组织免受潜在安全漏洞的影响。

这不是假设的风险;许多涉及 ChatGPT 的潜在网络安全漏洞的报告已经发布。在这篇博文中,我们探讨了这些风险,并找出哪种安全解决方案可以帮助防止数据泄露漏洞。

详细了解 LayerX 浏览器安全解决方案如何保护您的组织免受因员工使用 ChatGPT 或其他生成式 AI 工具而导致的潜在数据泄露。 点击此处了解详情

ChatGPT 的数据保护盲点

臭名昭著的三星 ChatGPT 漏洞(很快成为生成式 AI 网络安全漏洞的“SolarWinds”)已成为困扰生成式 AI 平台的网络安全漏洞的典型例子。在三星的灾难中,工程师将专有代码粘贴到 ChatGPT 中。由于粘贴在 ChatGPT 中的所有内容都可以用于培训和向其他用户提供答案,因此这些工程师可能会与任何知道如何向 ChatGPT 提出正确问题的竞争对手共享机密代码。

ChatGPT 可能看起来是一个客观的、提高生产力的工具。然而,它实际上是一个潜在的数据泄露渠道。顺带一提,当询问 ChatGPT 是否存在数据泄露的可能性时,答案是“作为一个 AI 语言模型,我没有任何内在的动机或能力泄露数据。然而,任何存储数据的系统都存在数据泄露或其他安全漏洞的潜在风险……”

安全研究人员已经演示了如何利用 ChatGPT 及其 API 编写恶意软件,如何 ChatGPT 漏洞导致个人数据泄露,甚至如何使用提示来提取其他用户共享的敏感信息。鉴于生成式人工智能平台有望在未来几年获得更大的普及,安全利益相关者和团队有责任确保其组织不会因人为错误、谬误或其他原因而将其皇冠上的宝石信息泄露到公共互联网上。只是单纯的天真。

DLP 和 CASB 的不足之处

传统上,企业依靠 DLP(数据泄露防护)解决方案来保护敏感的组织数据免遭未经授权的访问或分发。 DLP 监视组织中敏感数据的流动。一旦他们发现策略被违反,例如未经授权的用户试图访问受限资源, DLP 将采取行动并作出相应回应。这可能包括阻止数据或提醒管理员。还可以使用 CASB 解决方案来保护敏感数据不被传输到组织外部。

然而,DLP 和 CASB解决方案 是面向文件的。这意味着,虽然它们会阻止数据修改、下载或共享等操作,但这种阻止会应用于文件。当员工在 ChatGPT 网站上的浏览器中输入或粘贴数据时,DLP 和 CASB 毫无用处。这些基于浏览器的操作超出了他们的管理和控制范围。

什么是浏览器安全?

浏览器安全是指能够访问 SaaS 应用程序和网站,同时保护组织系统和数据的技术、工具、平台和实践。通过利用浏览器安全解决方案,公司可以检测和防止针对浏览器或将其用作攻击媒介的基于 Web 的威胁和风险。此类威胁包括恶意软件、社会工程、数据盗窃和数据泄露。

与网络和端点安全解决方案不同,浏览器安全平台专注于实时 Web 会话活动,其中包括浏览器呈现和显示的实际非加密网页。浏览器安全解决方案通过活动策略识别和阻止网络威胁、防止数据共享、执行最低权限、提供可见性、检测恶意活动以及保护托管设备和 BYOD/第三方设备。因此,它们可用于保护 ChatGPT 中的活动。

LayerX 浏览器安全解决方案如何防止 ChatGPT 数据泄露

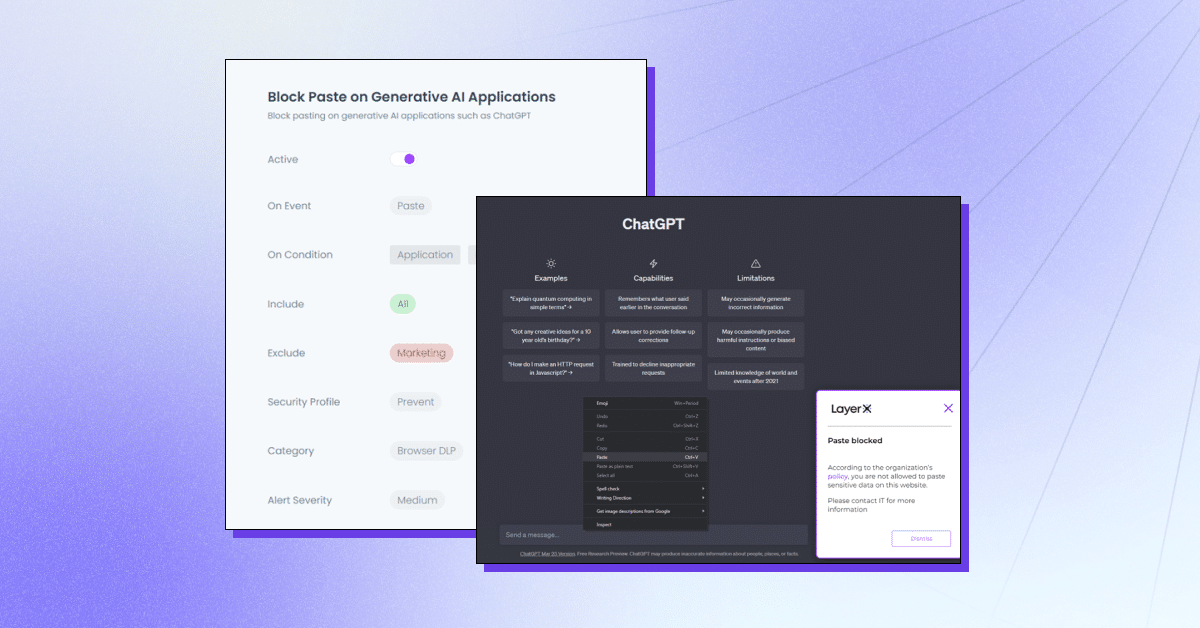

LayerX 是一个用户至上的浏览器安全平台,可与任何商业浏览器配合使用,将其变成最受保护和可管理的工作空间。 LayerX 持续监控和分析浏览器会话以实时实施保护。通过对会话中发生的每个事件的精细可见性,layerX 可以挑出文本插入事件。所有安全团队需要做的就是定义一个策略,通过 ChatGPT 选项卡限制或阻止此功能。该策略可以是包罗万象的,即完全阻止使用 ChatGPT,或者阻止特定字符串的使用。

LayerX 提供多种功能来防止 ChatGPT 数据泄露:

- 防止数据粘贴或提交 – 确保员工不会将敏感信息添加到生成式人工智能平台中。

- 检测敏感数据类型 – 识别员工何时向 ChatGPT 提交敏感数据并对其进行限制。

- 警告模式 – 通过添加“安全使用”指南,在使用 ChatGPT 时参与员工培训。

- 网站屏蔽或禁用 – 完全阻止使用 ChatGPT 或类似 ChatGPT 的浏览器扩展。

- 需要用户同意/理由 – 确保生成式人工智能工具的使用得到批准。

LayerX 将保护您的组织免受因员工使用 ChatGPT 或其他生成式 AI 工具而可能导致的潜在数据泄露。 了解更多信息。