ChatGPT comptant 1.16 milliard d'utilisateurs, il est devenu une partie indissociable de la vie de nombreuses personnes. Cette base d'utilisateurs importante oblige les équipes de sécurité et informatiques à trouver et à mettre en œuvre dans leur pile une solution capable de protéger l'organisation de ses vulnérabilités de sécurité potentielles.

Il ne s’agit pas d’un risque hypothétique ; de nombreux rapports faisant état de violations potentielles de la cybersécurité impliquant ChatGPT ont déjà été publiés. Dans cet article de blog, nous explorons ces risques et découvrons quelle solution de sécurité peut aider à protéger contre la vulnérabilité de fuite de données.

Pour en savoir plus sur la façon dont la solution de sécurité du navigateur LayerX peut protéger votre organisation contre les fuites de données potentielles qui pourraient résulter de l'utilisation par les employés de ChatGPT ou d'autres outils d'IA générative. En savoir plus ici

Les angles morts de ChatGPT en matière de protection des données

La tristement célèbre fuite Samsung ChatGPT (qui est rapidement devenue le « SolarWinds » des failles de cybersécurité de l'IA générative) est devenue un exemple représentatif des vulnérabilités de cybersécurité qui affligent les plateformes d'IA générative. Lors de la débâcle de Samsung, les ingénieurs ont collé du code propriétaire dans ChatGPT. Puisque tout ce qui est collé dans ChatGPT pourrait être utilisé pour la formation et pour les réponses données aux autres utilisateurs, ces ingénieurs partagent potentiellement du code confidentiel avec tous les concurrents qui savent poser les bonnes questions à ChatGPT.

ChatGPT peut sembler être un outil objectif et axé sur la productivité. Cependant, il s’agit en réalité d’un canal potentiel de fuite de données. Par ailleurs, lorsque l’on demande à ChatGPT s’il présente un potentiel de fuite de données, la réponse est « En tant que modèle de langage d’IA, je n’ai aucune motivation ou capacité inhérente à divulguer des données. Cependant, tout système qui stocke des données présente un risque potentiel de fuite de données ou d’autres vulnérabilités de sécurité… »

Les chercheurs en sécurité ont déjà démontré comment ChatGPT et ses API peuvent être exploités pour écrire des logiciels malveillants, Comment Les bugs de ChatGPT ont créé des fuites de données personnelles, et même comment les invites peuvent être utilisées pour extraire des informations sensibles partagées par d'autres utilisateurs. Étant donné que les plates-formes d'IA générative sont sur le point de gagner en popularité dans les années à venir, il appartient aux parties prenantes et aux équipes de sécurité de protéger leur organisation contre la possibilité que les informations de leurs joyaux soient divulguées sur l'Internet public, en raison d'une erreur humaine, d'une erreur ou d'une erreur. tout simplement de la naïveté.

Où DLP et CASB échouent

Traditionnellement, les entreprises s'appuyaient sur des solutions DLP (Data Leak Prevention) pour protéger les données organisationnelles sensibles contre tout accès ou distribution non autorisé. Les DLP surveillent le flux de données sensibles dans l’organisation. Une fois qu'ils identifient une violation de la politique, par exemple un utilisateur non autorisé tentant d'accéder à une ressource restreinte, le DLP prendra des mesures et réagira en conséquence. Cela peut inclure le blocage des données ou l’alerte des administrateurs. Les solutions CASB peuvent également être utilisées pour empêcher la transmission de données sensibles en dehors de l'organisation.

Cependant, DLP et Solutions CASB sont orientés fichiers. Cela signifie que même s'ils empêchent des actions telles que la modification, le téléchargement ou le partage de données, cette prévention est appliquée aux fichiers. Lorsque les employés saisissent ou collent des données dans le navigateur du site Web ChatGPT, les DLP et les CASB ne sont d'aucune utilité. Ces actions basées sur le navigateur échappent à leur gouvernance et à leur contrôle.

Qu'est-ce que la sécurité du navigateur ?

La sécurité du navigateur correspond aux technologies, outils, plates-formes et pratiques qui permettent d'accéder aux applications et sites Web SaaS tout en protégeant les systèmes et les données de l'organisation. En utilisant une solution de sécurité du navigateur, les entreprises peuvent détecter et prévenir les menaces et les risques Web qui ciblent le navigateur ou l'utilisent comme vecteur d'attaque. Ces menaces incluent les logiciels malveillants, l’ingénierie sociale, le vol de données et l’exfiltration de données.

Contrairement aux solutions de sécurité des réseaux et des points de terminaison, les plates-formes de sécurité des navigateurs se concentrent sur l'activité des sessions Web en direct, qui englobe les pages Web non cryptées que les navigateurs affichent et affichent. Les solutions de sécurité des navigateurs fonctionnent en identifiant et en bloquant les menaces véhiculées par le Web, via des politiques d'activité, en empêchant le partage de données, en appliquant le principe du moindre privilège, en offrant une visibilité, en détectant les activités malveillantes et en sécurisant les appareils gérés et BYOD/tiers. En tant que tels, ils peuvent être utilisés pour sécuriser les activités dans ChatGPT.

Comment la solution de sécurité du navigateur LayerX empêche les fuites de données vers ChatGPT

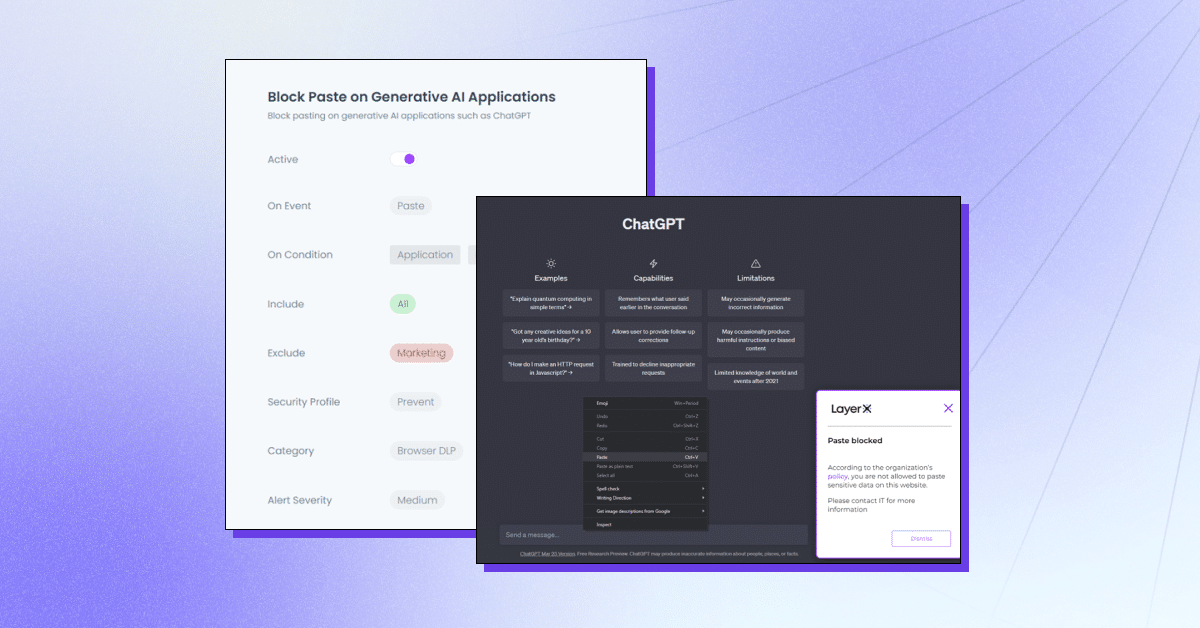

LayerX est une plate-forme de sécurité de navigateur axée sur l'utilisateur qui fonctionne avec n'importe quel navigateur commercial, ce qui en fait l'espace de travail le plus protégé et le plus gérable. LayerX surveille et analyse en permanence les sessions du navigateur pour renforcer leur protection en temps réel. Grâce à une visibilité granulaire sur chaque événement qui se déroule au cours de la session, layerX peut distinguer les événements d'insertion de texte. Tout ce que les équipes de sécurité doivent faire est de définir une politique qui limite ou bloque cette capacité avec l'onglet ChatGPT. Cette politique peut être globale, c'est-à-dire empêcher complètement l'utilisation de ChatGPT ou pour des chaînes spécifiques.

LayerX offre plusieurs fonctionnalités pour se protéger contre les fuites de données ChatGPT :

- Empêcher le collage ou la soumission de données – S'assurer que les employés n'ajoutent pas d'informations sensibles dans la plateforme Generative AI.

- Détection de la saisie de données sensibles – Identifier quand les employés sont sur le point de soumettre des données sensibles à ChatGPT et les restreindre.

- Mode d'avertissement – Participer à la formation des employés pendant qu'ils utilisent ChatGPT en ajoutant des directives « d'utilisation sûre ».

- Blocage ou désactivation du site – Empêcher complètement l’utilisation de ChatGPT ou d’extensions de navigateur de type ChatGPT.

- Exiger le consentement/justification de l'utilisateur – Veiller à ce que l’utilisation d’un outil d’IA générative soit approuvée.

LayerX protégera votre organisation contre les fuites de données potentielles qui pourraient résulter de l'utilisation par les employés de ChatGPT ou d'autres outils d'IA générative. En savoir plus ici.