Omdat ChatGPT 1.16 miljard gebruikers telt, is het een onlosmakelijk onderdeel geworden van het leven van veel mensen. Deze aanzienlijke gebruikersbasis vereist dat beveiligings- en IT-teams een oplossing in hun stack vinden en implementeren die de organisatie kan beschermen tegen potentiële beveiligingsproblemen.

Dit is geen hypothetisch risico; Er zijn al talloze rapporten gepubliceerd over mogelijke inbreuken op de cyberbeveiliging waarbij ChatGPT betrokken is. In deze blogpost onderzoeken we deze risico's en ontdekken we welke beveiligingsoplossing kan helpen beschermen tegen de kwetsbaarheid voor gegevenslekken.

Lees meer over hoe de LayerX-browserbeveiligingsoplossing uw organisatie kan beschermen tegen mogelijke gegevenslekken die kunnen voortvloeien uit het gebruik door medewerkers van ChatGPT of andere generatieve AI-tools. Meer informatie hier

Blinde vlekken op het gebied van gegevensbescherming van ChatGPT

Het beruchte Samsung ChatGPT-lek (dat snel de ‘SolarWinds’ van generatieve AI-cyberbeveiligingsinbreuken aan het worden is) is een representatief voorbeeld geworden van de cyberbeveiligingskwetsbaarheden die generatieve AI-platforms teisteren. In het Samsung-debacle plakten ingenieurs eigen code in ChatGPT. Omdat alles wat in ChatGPT wordt geplakt, kan worden gebruikt voor training en voor de antwoorden die aan andere gebruikers worden gegeven, delen deze ingenieurs mogelijk vertrouwelijke code met concurrenten die weten hoe ze ChatGPT de juiste vragen moeten stellen.

ChatGPT lijkt misschien een objectieve, productiviteitsverhogende tool. Het is echter feitelijk een potentieel kanaal voor gegevenslekken. Wanneer je ChatGPT vraagt of er potentieel datalekken zijn, is het antwoord overigens: “Als AI-taalmodel heb ik geen enkele inherente motivatie of mogelijkheid om data te lekken. Elk systeem dat gegevens opslaat, heeft echter een potentieel risico op gegevenslekken of andere beveiligingsproblemen...'

Beveiligingsonderzoekers hebben al aangetoond hoe ChatGPT en zijn API's kunnen worden uitgebuit malware schrijven, hoe ChatGPT-bugs zorgden voor lekken van persoonlijke gegevens, en zelfs hoe prompts kunnen worden gebruikt om gevoelige informatie te extraheren die door andere gebruikers wordt gedeeld. Gezien het feit dat generatieve AI-platforms de komende jaren steeds populairder zullen worden, is het aan de veiligheidsbelanghebbenden en teams om hun organisatie te beschermen tegen de mogelijkheid dat informatie over hun kroonjuwelen op het openbare internet terechtkomt, als gevolg van menselijke fouten, misvattingen of misvattingen. gewoon pure naïviteit.

Waar DLP en CASB tekortschieten

Traditioneel vertrouwden ondernemingen op DLP-oplossingen (Data Leak Prevention) om gevoelige organisatiegegevens te beschermen tegen ongeoorloofde toegang of distributie. DLP's bewaken de stroom van gevoelige gegevens in de organisatie. Zodra ze vaststellen dat een beleid wordt geschonden, bijvoorbeeld een ongeautoriseerde gebruiker die probeert toegang te krijgen tot een beperkte bron, de DLP zal actie ondernemen en dienovereenkomstig reageren. Dit kan het blokkeren van de gegevens omvatten of het waarschuwen van beheerders. CASB-oplossingen kunnen ook worden gebruikt om te voorkomen dat gevoelige gegevens buiten de organisatie worden verzonden.

Zowel DLP als CASB-oplossingen zijn bestandgericht. Dit betekent dat hoewel ze acties zoals het wijzigen, downloaden of delen van gegevens voorkomen, deze preventie wordt toegepast op bestanden. Als werknemers gegevens in de browser van de ChatGPT-website typen of plakken, hebben DLP's en CASB's geen zin. Deze browsergebaseerde acties vallen buiten hun bestuur en controle.

Wat is browserbeveiliging?

Browserbeveiliging bestaat uit de technologieën, tools, platforms en praktijken die toegang tot SaaS-applicaties en websites mogelijk maken en tegelijkertijd de systemen en gegevens van de organisatie beschermen. Door gebruik te maken van een browserbeveiligingsoplossing kunnen bedrijven webgebaseerde bedreigingen en risico's detecteren en voorkomen die zich op de browser richten of deze als aanvalsvector gebruiken. Dergelijke bedreigingen omvatten malware, social engineering, gegevensdiefstal en gegevensexfiltratie.

In tegenstelling tot netwerk- en eindpuntbeveiligingsoplossingen richten browserbeveiligingsplatforms zich op live websessie-activiteit, die de daadwerkelijke niet-gecodeerde webpagina's omvat die browsers weergeven en weergeven. Browserbeveiligingsoplossingen werken door het identificeren en blokkeren van bedreigingen via het internet, door middel van activiteitenbeleid, het voorkomen van het delen van gegevens, het afdwingen van minimale bevoegdheden, het bieden van zichtbaarheid, het detecteren van kwaadaardige activiteiten en het beveiligen van zowel beheerde apparaten als BYOD/apparaten van derden. Als zodanig kunnen ze worden gebruikt voor het beveiligen van activiteiten in ChatGPT.

Hoe de LayerX-browserbeveiligingsoplossing gegevenslekken naar ChatGPT voorkomt

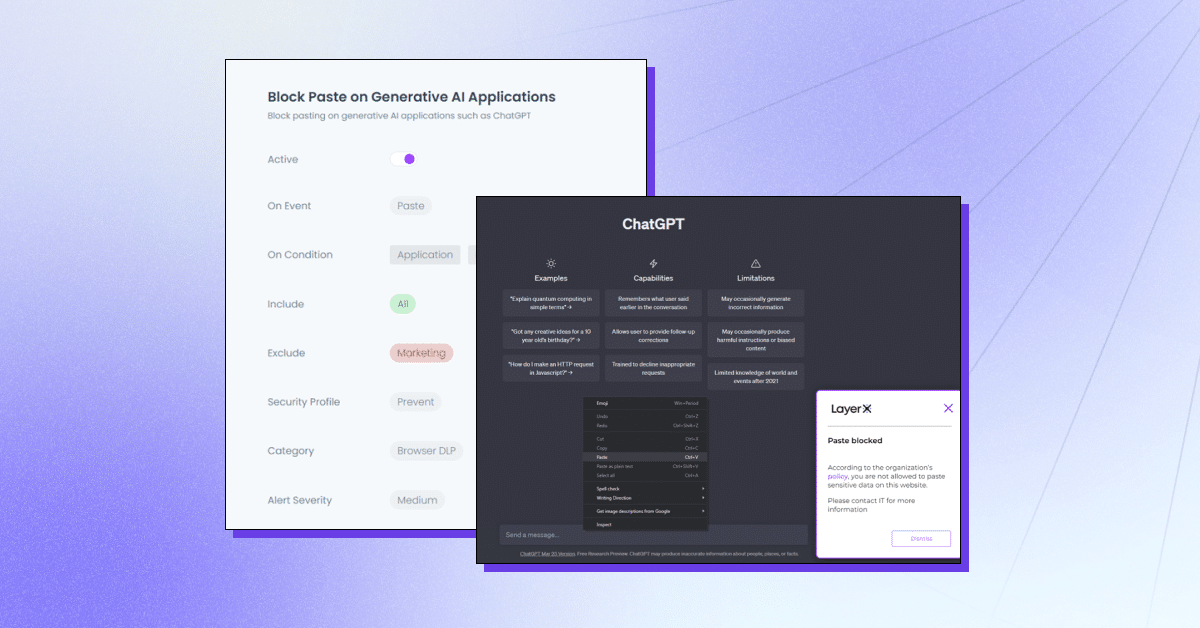

LayerX is een gebruikersgericht browserbeveiligingsplatform dat met elke commerciële browser werkt, waardoor het de meest beschermde en beheersbare werkruimte wordt. LayerX bewaakt en analyseert voortdurend browsersessies om hun bescherming in realtime af te dwingen. Door gedetailleerd inzicht in elke gebeurtenis die plaatsvindt in de sessie, kan LayerX tekstinvoeggebeurtenissen onderscheiden. Het enige dat beveiligingsteams hoeven te doen, is een beleid definiëren dat deze mogelijkheid beperkt of blokkeert via het tabblad ChatGPT. Dit beleid kan allesomvattend zijn, dwz het gebruik van ChatGPT geheel of voor specifieke strings voorkomen.

LayerX's biedt meerdere mogelijkheden om te beschermen tegen ChatGPT-datalekken:

- Voorkomen dat gegevens worden geplakt of verzonden – Ervoor zorgen dat werknemers geen gevoelige informatie toevoegen aan het Generative AI-platform.

- Het detecteren van het typen van gevoelige gegevens – Identificeren wanneer werknemers op het punt staan gevoelige gegevens naar ChatGPT te verzenden en deze te beperken.

- Waarschuwingsmodus – Deelnemen aan training van medewerkers terwijl ze ChatGPT gebruiken door richtlijnen voor veilig gebruik toe te voegen.

- Site blokkeren of uitschakelen – Het voorkomen van het gebruik van ChatGPT of ChatGPT-achtige browserextensies.

- Vereist toestemming/rechtvaardiging van de gebruiker – Ervoor zorgen dat het gebruik van een generatieve AI-tool wordt goedgekeurd.

LayerX beschermt uw organisatie tegen mogelijke gegevenslekken die kunnen voortvloeien uit het gebruik door medewerkers van ChatGPT of andere generatieve AI-tools. Meer informatie hier.