Com o ChatGPT tendo 1.16 bilhão de usuários, ele se tornou uma parte inseparável da vida de muitas pessoas. Essa base significativa de usuários exige que as equipes de segurança e de TI encontrem e implementem uma solução em sua pilha que possa proteger a organização contra possíveis vulnerabilidades de segurança.

Este não é um risco hipotético; numerosos relatórios de potenciais violações de segurança cibernética envolvendo ChatGPT já foram publicados. Nesta postagem do blog, exploramos esses riscos e descobrimos qual solução de segurança pode ajudar a proteger contra a vulnerabilidade de vazamento de dados.

Para ler mais sobre como a solução de segurança de navegador LayerX pode proteger sua organização contra possível vazamento de dados que pode resultar do uso do ChatGPT ou de outras ferramentas de IA generativa pelos funcionários. Saiba mais aqui

Pontos cegos de proteção de dados do ChatGPT

O infame vazamento do Samsung ChatGPT (que está rapidamente se tornando o ‘SolarWinds’ das violações de segurança cibernética de IA generativa) tornou-se um exemplo representativo das vulnerabilidades de segurança cibernética que afetam as plataformas de IA generativa. No desastre da Samsung, os engenheiros colaram código proprietário no ChatGPT. Como tudo colado no ChatGPT pode ser usado para treinamento e para respostas dadas a outros usuários, esses engenheiros potencialmente compartilham código confidencial com quaisquer concorrentes que saibam como fazer as perguntas certas ao ChatGPT.

ChatGPT pode parecer uma ferramenta objetiva que impulsiona a produtividade. No entanto, é na verdade um canal potencial de vazamento de dados. Aliás, ao perguntar ao ChatGPT se ele tem potencial para vazamento de dados, a resposta é “Como um modelo de linguagem de IA, não tenho nenhuma motivação ou capacidade inerente para vazar dados. No entanto, qualquer sistema que armazene dados apresenta um risco potencial de vazamento de dados ou outras vulnerabilidades de segurança…”

Pesquisadores de segurança já demonstraram como o ChatGPT e suas APIs podem ser explorados para escrever malware, Como Bugs do ChatGPT criaram vazamentos de dados pessoaise até mesmo como os prompts podem ser usados para extrair informações confidenciais compartilhadas por outros usuários. Dado que as plataformas de IA generativa estão preparadas para ganhar maior popularidade nos próximos anos, cabe às partes interessadas e às equipes de segurança proteger suas organizações da possibilidade de vazamento de informações sobre a joia da coroa na Internet pública, devido a erro humano, falácia ou simplesmente ingenuidade.

Onde DLP e CASB ficam aquém

Tradicionalmente, as empresas dependiam de soluções DLP (Data Leak Prevention) para proteger dados organizacionais confidenciais contra acesso ou distribuição não autorizada. Os DLPs monitoram o fluxo de dados confidenciais na organização. Assim que identificarem uma política violada, por exemplo, um usuário não autorizado tentando acessar um recurso restrito, o DLP tomará medidas e responderá de acordo. Isso pode incluir bloquear os dados ou alertar os administradores. Soluções CASB também podem ser usadas para proteger dados confidenciais contra transmissão para fora da organização.

No entanto, tanto o DLP quanto o Soluções CASB são orientados a arquivos. Isso significa que, embora impeçam ações como modificação, download ou compartilhamento de dados, essa prevenção é aplicada aos arquivos. Com os funcionários digitando ou colando dados no navegador do site ChatGPT, DLPs e CASBs são inúteis. Estas ações baseadas no navegador estão além da sua governança e controle.

O que é segurança do navegador?

A segurança do navegador são as tecnologias, ferramentas, plataformas e práticas que permitem o acesso a aplicativos e sites SaaS, ao mesmo tempo que protegem os sistemas e dados organizacionais. Ao utilizar uma solução de segurança de navegador, as empresas podem detectar e prevenir ameaças e riscos baseados na Web que visam o navegador ou usá-lo como vetor de ataque. Essas ameaças incluem malware, engenharia social, roubo e exfiltração de dados.

Ao contrário das soluções de rede e de segurança de endpoint, as plataformas de segurança de navegador se concentram na atividade de sessão da Web ao vivo, que abrange as páginas da Web reais não criptografadas que os navegadores renderizam e exibem. As soluções de segurança do navegador operam identificando e bloqueando ameaças transmitidas pela Web, por meio de políticas de atividade, evitando o compartilhamento de dados, impondo privilégios mínimos, fornecendo visibilidade, detectando atividades maliciosas e protegendo dispositivos gerenciados e BYOD/de terceiros. Como tal, eles podem ser usados para proteger atividades no ChatGPT.

Como a solução de segurança do navegador LayerX evita vazamentos de dados para ChatGPT

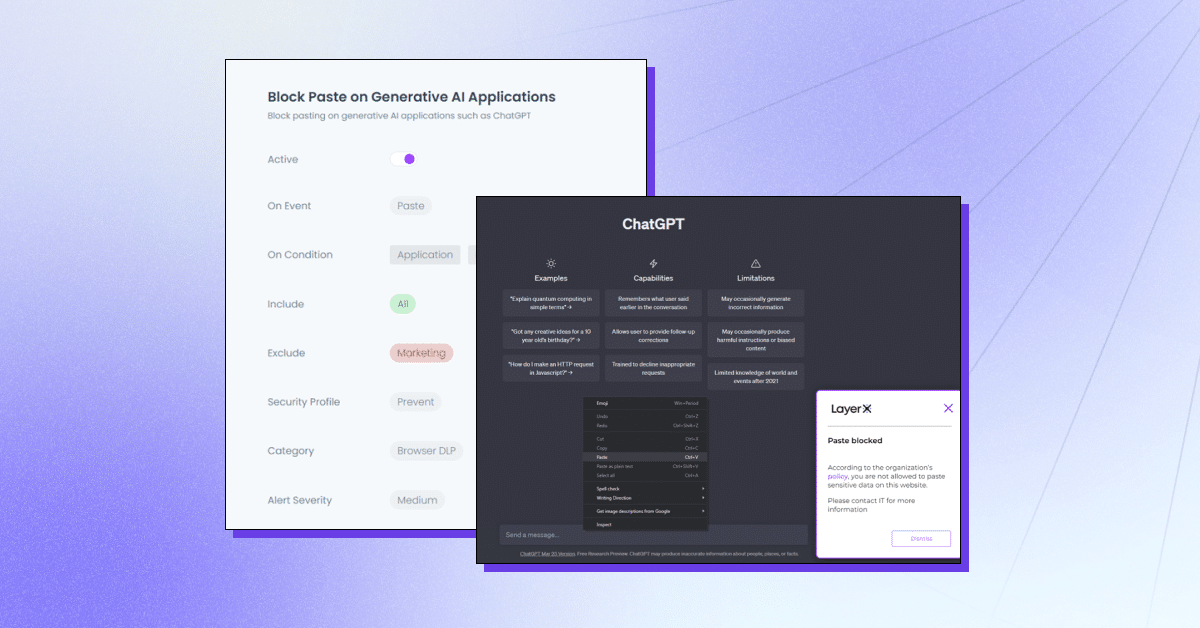

LayerX é uma plataforma de segurança de navegador que prioriza o usuário e funciona com qualquer navegador comercial, transformando-o no espaço de trabalho mais protegido e gerenciável. LayerX monitora e analisa continuamente as sessões do navegador para reforçar sua proteção em tempo real. Através da visibilidade granular de cada evento que ocorre na sessão, o layerX pode destacar eventos de inserção de texto. Tudo o que as equipes de segurança precisam fazer é definir uma política que limite ou bloqueie essa capacidade com a guia ChatGPT. Esta política pode ser abrangente, ou seja, impedir o uso do ChatGPT por completo ou para strings específicas.

O LayerX oferece vários recursos para proteção contra vazamento de dados ChatGPT:

- Impedindo a colagem ou envio de dados – Garantir que os funcionários não adicionem informações confidenciais à plataforma de IA generativa.

- Detectando digitação de dados confidenciais – Identificar quando os funcionários estão prestes a enviar dados confidenciais ao ChatGPT e restringi-los.

- Modo de aviso – Participar de treinamento de funcionários enquanto eles usam o ChatGPT, adicionando diretrizes de “uso seguro”.

- Bloqueio ou desativação de sites – Impedir totalmente o uso do ChatGPT ou de extensões de navegador semelhantes ao ChatGPT.

- Exigir consentimento/justificativa do usuário – Garantir que o uso de uma ferramenta generativa de IA seja aprovado.

LayerX protegerá sua organização contra possível vazamento de dados que pode resultar do uso do ChatGPT ou de outras ferramentas de IA generativa pelos funcionários. Saiba mais aqui.