Med ChatGPT som 1.16 milliarder brukere, har det blitt en uatskillelig del av mange menneskers liv. Denne betydelige brukerbasen krever at sikkerhets- og IT-team finner og implementerer en løsning i stabelen deres som kan beskytte organisasjonen mot dens potensielle sikkerhetssårbarheter.

Dette er ikke en hypotetisk risiko; tallrike rapporter om potensielle cybersikkerhetsbrudd som involverer ChatGPT har allerede blitt publisert. I dette blogginnlegget utforsker vi disse risikoene og finner ut hvilken sikkerhetsløsning som kan bidra til å beskytte mot sårbarheten for datalekkasje.

For å lese mer om hvordan LayerX nettlesersikkerhetsløsning kan beskytte organisasjonen din mot potensiell datalekkasje som kan skyldes ansattes bruk av ChatGPT eller andre Generative AI-verktøy. Les mer her

ChatGPTs databeskyttelses blindsoner

Den beryktede Samsung ChatGPT-lekkasjen (som raskt blir "SolarWinds" for generative AI-cybersikkerhetsbrudd) har blitt et representativt eksempel på cybersikkerhetssårbarhetene som plager generative AI-plattformer. I Samsung-debakelen limte ingeniører inn proprietær kode i ChatGPT. Siden alt som er limt inn i ChatGPT kan brukes til opplæring og til svarene som er gitt til andre brukere, deler disse ingeniørene potensielt konfidensiell kode med alle konkurrenter som vet hvordan de skal stille ChatGPT de riktige spørsmålene.

ChatGPT kan virke som et objektivt, produktivitetsdrivende verktøy. Imidlertid er det faktisk en potensiell datalekkasjekanal. Forresten, når du spør ChatGPT om det har potensial for datalekkasje, er svaret "Som en AI-språkmodell har jeg ingen iboende motivasjon eller evne til å lekke data. Imidlertid har ethvert system som lagrer data en potensiell risiko for datalekkasje eller andre sikkerhetssårbarheter ..."

Sikkerhetsforskere har allerede demonstrert hvordan ChatGPT og dets APIer kan utnyttes til skrive skadelig programvare, hvordan ChatGPT-feil skapte lekkasjer av personlige data, og til og med hvordan forespørsler kan brukes til å trekke ut sensitiv informasjon som deles av andre brukere. Gitt at Generative AI-plattformer er klar til å få større popularitet i de kommende årene, er det opp til sikkerhetsinteressenter og -team å sikre organisasjonen deres mot muligheten for at kronjuvelinformasjonen deres lekkes ut på det offentlige internett på grunn av menneskelig feil, feilslutning eller rett og slett naivitet.

Hvor DLP og CASB kommer til kort

Tradisjonelt stolte bedrifter på DLP-løsninger (Data Leak Prevention) for å beskytte sensitive organisasjonsdata mot uautorisert tilgang eller distribusjon. DLP-er overvåker flyten av sensitive data i organisasjonen. Når de identifiserer en policy som brytes, for eksempel en uautorisert bruker som forsøker å få tilgang til en begrenset ressurs, DLP vil iverksette tiltak og svare deretter. Dette kan inkludere blokkering av dataene eller varsle administratorer. CASB-løsninger kan også brukes for å beskytte sensitive data fra å bli overført utenfor organisasjonen.

Men både DLP og CASB løsninger er filorienterte. Dette betyr at mens de forhindrer handlinger som modifisering av data, nedlasting eller deling, brukes denne forebyggingen på filer. Med ansatte som skriver eller limer inn data i nettleseren på ChatGPT-nettstedet, er DLP-er og CASB-er til ingen nytte. Disse nettleserbaserte handlingene er utenfor deres styring og kontroll.

Hva er nettlesersikkerhet?

Nettlesersikkerhet er teknologiene, verktøyene, plattformene og praksisene som muliggjør tilgang til SaaS-applikasjoner og nettsteder samtidig som de beskytter organisasjonssystemene og dataene. Ved å bruke en nettlesersikkerhetsløsning kan bedrifter oppdage og forhindre nettbaserte trusler og risikoer som retter seg mot nettleseren eller bruke den som en angrepsvektor. Slike trusler inkluderer skadelig programvare, social engineering, datatyveri og dataeksfiltrering.

I motsetning til nettverks- og endepunktsikkerhetsløsninger, fokuserer nettlesersikkerhetsplattformer på live nettøktaktivitet, som omfatter de faktiske ikke-krypterte nettsidene som nettlesere gjengir og viser. Nettlesersikkerhetsløsninger fungerer ved å identifisere og blokkere nettbårne trusler, gjennom aktivitetspolicyer, forhindre datadeling, håndheve minste privilegium, gi synlighet, oppdage ondsinnede aktiviteter og sikre både administrerte og BYOD/tredjepartsenheter. Som sådan kan de brukes til å sikre aktiviteter i ChatGPT.

Hvordan LayerX Browser Security Solution forhindrer datalekkasjer til ChatGPT

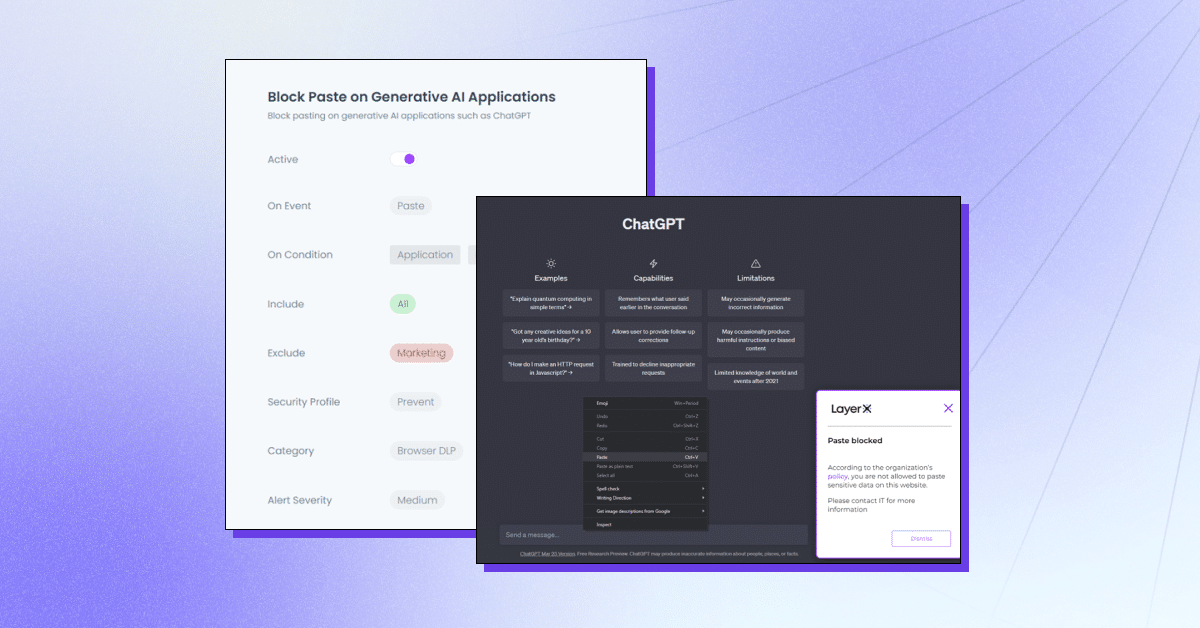

LayerX er en brukerførste nettlesersikkerhetsplattform som fungerer med enhver kommersiell nettleser, og gjør den til det mest beskyttede og håndterbare arbeidsområdet. LayerX overvåker og analyserer kontinuerlig nettleserøkter for å håndheve beskyttelsen deres i sanntid. Gjennom granulert synlighet i hver hendelse som finner sted i økten, kan layerX skille ut tekstinnsettingshendelser. Alt sikkerhetsteam trenger å gjøre er å definere en policy som begrenser eller blokkerer denne muligheten med ChatGPT-fanen. Denne policyen kan være altomfattende, dvs. forhindre bruk av ChatGPT helt, eller for spesifikke strenger.

LayerX tilbyr flere funksjoner for å beskytte mot ChatGPT-datalekkasje:

- Forhindrer innliming eller innsending av data – Sikre at ansatte ikke legger til sensitiv informasjon i Generative AI-plattformen.

- Oppdager sensitive dataskriving – Identifisere når ansatte er i ferd med å sende inn sensitive data til ChatGPT og begrense det.

- Advarselmodus – Delta i opplæring av ansatte mens de bruker ChatGPT ved å legge til retningslinjer for "sikker bruk".

- Nettstedet blokkerer eller deaktiverer – Forhindre bruk av ChatGPT helt eller ChatGPT-lignende nettleserutvidelser.

- Krev brukersamtykke/begrunnelse – Sikre at bruken av et generativt AI-verktøy er godkjent.

LayerX vil beskytte organisasjonen din mot potensiell datalekkasje som kan skyldes ansattes bruk av ChatGPT eller andre Generative AI-verktøy. Les mer her.