Da ChatGPT 1.16 Milliarden Nutzer hat, ist es zu einem untrennbaren Teil des Lebens vieler Menschen geworden. Diese große Benutzerbasis erfordert, dass Sicherheits- und IT-Teams eine Lösung in ihrem Stack finden und implementieren, die das Unternehmen vor potenziellen Sicherheitslücken schützen kann.

Dies ist kein hypothetisches Risiko; Zahlreiche Berichte über potenzielle Cybersicherheitsverstöße im Zusammenhang mit ChatGPT wurden bereits veröffentlicht. In diesem Blogbeitrag untersuchen wir diese Risiken und finden heraus, welche Sicherheitslösung zum Schutz vor der Sicherheitslücke durch Datenlecks beitragen kann.

Erfahren Sie mehr darüber, wie die LayerX-Browsersicherheitslösung Ihr Unternehmen vor potenziellen Datenlecks schützen kann, die durch die Nutzung von ChatGPT oder anderen generativen KI-Tools durch Mitarbeiter entstehen können. Hier erfahren Sie mehr

Die blinden Flecken im Datenschutz von ChatGPT

Das berüchtigte Samsung ChatGPT-Leck (das sich schnell zum „SolarWinds“ der generativen KI-Cybersicherheitsverstöße entwickelt) ist zu einem repräsentativen Beispiel für die Cybersicherheitslücken geworden, die generative KI-Plattformen plagen. Beim Samsung-Debakel haben Ingenieure proprietären Code in ChatGPT eingefügt. Da alles, was in ChatGPT eingefügt wird, für Schulungen und für die Antworten an andere Benutzer verwendet werden könnte, geben diese Ingenieure möglicherweise vertraulichen Code an alle Konkurrenten weiter, die wissen, wie man ChatGPT die richtigen Fragen stellt.

ChatGPT scheint ein objektives, produktivitätssteigerndes Tool zu sein. Es handelt sich jedoch tatsächlich um einen potenziellen Datenleckkanal. Wenn man ChatGPT übrigens fragt, ob das Potenzial für Datenlecks besteht, lautet die Antwort: „Als KI-Sprachmodell habe ich keine inhärente Motivation oder Fähigkeit, Daten preiszugeben.“ Allerdings besteht bei jedem System, das Daten speichert, das potenzielle Risiko von Datenlecks oder anderen Sicherheitslücken…“

Sicherheitsforscher haben bereits gezeigt, wie ChatGPT und seine APIs ausgenutzt werden können Malware schreibenWie ChatGPT-Fehler führten zu Verlusten personenbezogener Datenund sogar, wie Eingabeaufforderungen verwendet werden können, um vertrauliche Informationen zu extrahieren, die von anderen Benutzern geteilt werden. Angesichts der Tatsache, dass generative KI-Plattformen in den kommenden Jahren zunehmend an Beliebtheit gewinnen werden, liegt es an den Sicherheitsakteuren und -teams, ihre Organisation vor der Möglichkeit zu schützen, dass ihre Kronjuweleninformationen aufgrund menschlicher Fehler, Täuschungen usw. ins öffentliche Internet gelangen einfach nur Naivität.

Wo DLP und CASB zu kurz kommen

Traditionell verließen sich Unternehmen auf DLP-Lösungen (Data Leak Prevention), um sensible Unternehmensdaten vor unbefugtem Zugriff oder unbefugter Verbreitung zu schützen. DLPs überwachen den Fluss sensibler Daten in der Organisation. Sobald sie feststellen, dass gegen eine Richtlinie verstoßen wird, beispielsweise wenn ein nicht autorisierter Benutzer versucht, auf eine eingeschränkte Ressource zuzugreifen, Das DLP wird Maßnahmen ergreifen und entsprechend reagieren. Dies kann das Sperren der Daten oder die Benachrichtigung der Administratoren umfassen. Es könnten auch CASB-Lösungen eingesetzt werden, um die Übertragung sensibler Daten außerhalb des Unternehmens zu verhindern.

Allerdings sind sowohl DLP als auch CASB-Lösungen sind dateiorientiert. Dies bedeutet, dass sie zwar Aktionen wie das Ändern, Herunterladen oder Teilen von Daten verhindern, diese Verhinderung jedoch auf Dateien angewendet wird. Da Mitarbeiter auf der ChatGPT-Website Daten in den Browser eingeben oder einfügen, sind DLPs und CASBs nutzlos. Diese browserbasierten Aktionen liegen außerhalb ihrer Kontrolle und Kontrolle.

Was ist Browsersicherheit?

Unter Browsersicherheit versteht man die Technologien, Tools, Plattformen und Praktiken, die den Zugriff auf SaaS-Anwendungen und Websites ermöglichen und gleichzeitig die Systeme und Daten der Organisation schützen. Durch den Einsatz einer Browser-Sicherheitslösung können Unternehmen webbasierte Bedrohungen und Risiken erkennen und verhindern, die auf den Browser abzielen oder ihn als Angriffsvektor nutzen. Zu diesen Bedrohungen gehören Malware, Social Engineering, Datendiebstahl und Datenexfiltration.

Im Gegensatz zu Netzwerk- und Endpunkt-Sicherheitslösungen konzentrieren sich Browser-Sicherheitsplattformen auf Live-Websitzungsaktivitäten, die die tatsächlichen unverschlüsselten Webseiten umfassen, die Browser rendern und anzeigen. Browser-Sicherheitslösungen funktionieren durch die Identifizierung und Blockierung webbasierter Bedrohungen, durch Aktivitätsrichtlinien, die Verhinderung der Datenfreigabe, die Durchsetzung der geringsten Rechte, die Bereitstellung von Transparenz, die Erkennung bösartiger Aktivitäten und die Sicherung sowohl verwalteter als auch BYOD-/Drittanbieter-Geräte. Daher können sie zur Absicherung von Aktivitäten in ChatGPT verwendet werden.

Wie die LayerX-Browser-Sicherheitslösung Datenlecks an ChatGPT verhindert

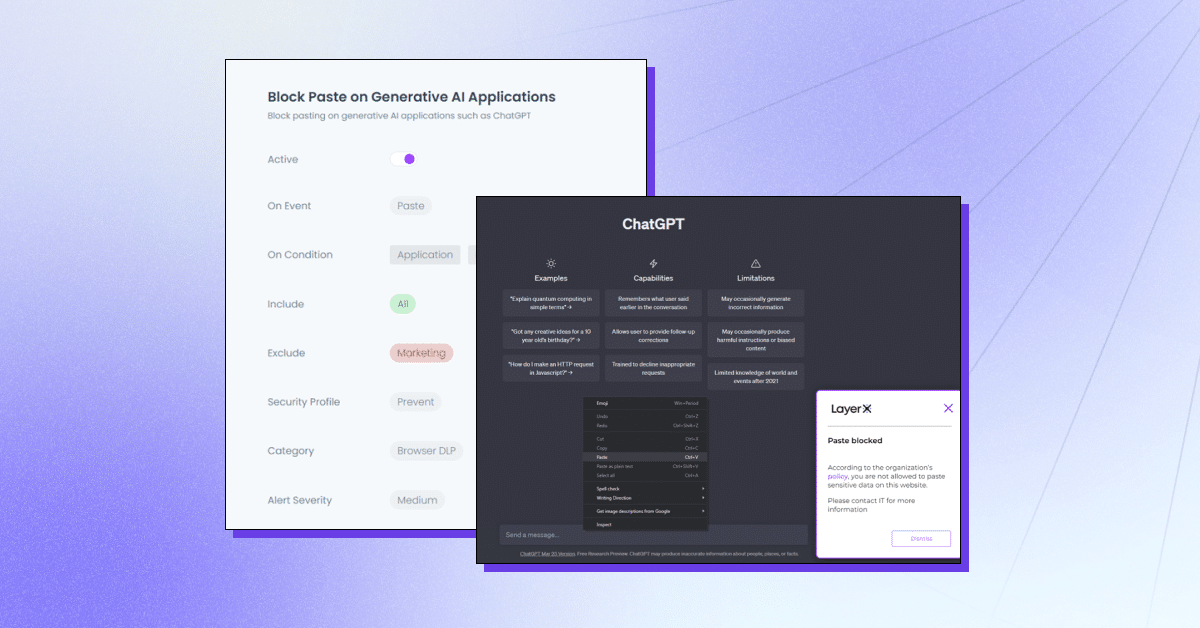

LayerX ist eine benutzerorientierte Browser-Sicherheitsplattform, die mit jedem kommerziellen Browser funktioniert und ihn zum am besten geschützten und verwaltbarsten Arbeitsbereich macht. LayerX überwacht und analysiert kontinuierlich Browsersitzungen, um deren Schutz in Echtzeit durchzusetzen. Durch detaillierte Einblicke in jedes Ereignis, das in der Sitzung stattfindet, kann LayerX Texteinfügungsereignisse herausgreifen. Sicherheitsteams müssen lediglich eine Richtlinie definieren, die diese Funktion auf der Registerkarte „ChatGPT“ einschränkt oder blockiert. Diese Richtlinie kann umfassend sein, dh die Verwendung von ChatGPT insgesamt oder für bestimmte Zeichenfolgen verhindern.

LayerX bietet mehrere Funktionen zum Schutz vor ChatGPT-Datenlecks:

- Verhindern des Einfügens oder Sendens von Daten – Sicherstellen, dass Mitarbeiter keine vertraulichen Informationen zur Generative AI-Plattform hinzufügen.

- Erkennen der Eingabe sensibler Daten – Identifizieren, wann Mitarbeiter vertrauliche Daten an ChatGPT übermitteln und diese einschränken.

- Warnmodus – Teilnahme an Mitarbeiterschulungen während der Nutzung von ChatGPT durch Hinzufügen von Richtlinien zur „sicheren Nutzung“.

- Blockieren oder Deaktivieren der Website – Verhindern Sie die Verwendung von ChatGPT insgesamt oder ChatGPT-ähnlichen Browsererweiterungen.

- Erfordern die Zustimmung/Begründung des Benutzers – Sicherstellen, dass der Einsatz eines generativen KI-Tools genehmigt ist.

LayerX schützt Ihr Unternehmen vor potenziellen Datenlecks, die durch die Nutzung von ChatGPT oder anderen generativen KI-Tools durch Mitarbeiter entstehen könnten. Erfahren Sie mehr hier.